相关推荐recommended

- SQL:查询结果升序、降序排列

- 图书管理系统2.0——mysql数据库

- 解决1130-Host‘ ‘is not allowed to con

- Python Flask 封装ChatGPT流式输出接口

- 【计算机毕业设计】鲜花销售管理系统

- LLMs之Code:SQLCoder的简介、安装、使用方法之详细攻略

- <SpringBoot笔记>SpringBoot版本降级

- 使用spring boot写一个学生管理系统

- 报错 com.alibaba.druid.pool.DruidData

- MySQL5.7和MySQL8.0的区别是什么

- 分布式消息中间件RocketMQ的安装与启动

- SpringBoot中Redis配置

- 使用nginx方向代理部署Vue项目刷新页面404的问题解决

- pgsql常用的sql函数总结

- Spring Boot 的版本与 MyBatis 或其他依赖库的版本不

- python新手案例——商品进销存管理系统(pymysql+xlwt)

- 计算机毕业设计:基于python机器学习的全国气象数据采集预测可视化系

- 【MySQL】不就是子查询

- Spring MVC异步上传、跨服务器上传和文件下载

- Linux部署web项目springboot项目(详细步骤)

- 【微服务|SpringBoot 3.0】 新特性——内置声明式HTTP

- Spring Boot 集成 EasyExcel 3.x 优雅实现Ex

- Win7安装VScode+Node.js

- 短信验证码—Java实现

- MySQL8.0.32详细安装教程(奶妈级手把手教你安装)

- MySQL用户创建

- JAVAWEB学生信息管理系统保姆级教程(增删改查+登录注册+Filt

- mysql-SQL从一个表查询数据插入更新到另一个表

- odoo17核心概念menu1——主菜单

- 【MySQL新手入门系列一】:手把手教你入门MySQL

Azure Machine Learning - Azure OpenAI 服务使用 GPT-35-Turbo and GPT-4

作者:mmseoamin日期:2023-12-11

通过 Azure OpenAI 服务使用 GPT-35-Turbo and GPT-4

环境准备

- Azure 订阅 - 免费创建订阅

- 已在所需的 Azure 订阅中授予对 Azure OpenAI 服务的访问权限。 目前,仅应用程序授予对此服务的访问权限。 可以填写 https://aka.ms/oai/access 处的表单来申请对 Azure OpenAI 服务的访问权限。

- Python 3.7.1 或更高版本。

- 以下 Python 库:os。

- 部署了 gpt-35-turbo 或 gpt-4 模型的 Azure OpenAI 服务资源。

设置

使用以下项安装 OpenAI Python 客户端库:

- [OpenAI Python 0.28.1]

- [OpenAI Python 1.x]

pip install openai==0.28.1

pip install openai

检索密钥和终结点

若要成功对 Azure OpenAI 发出调用,需要一个终结点和一个密钥。

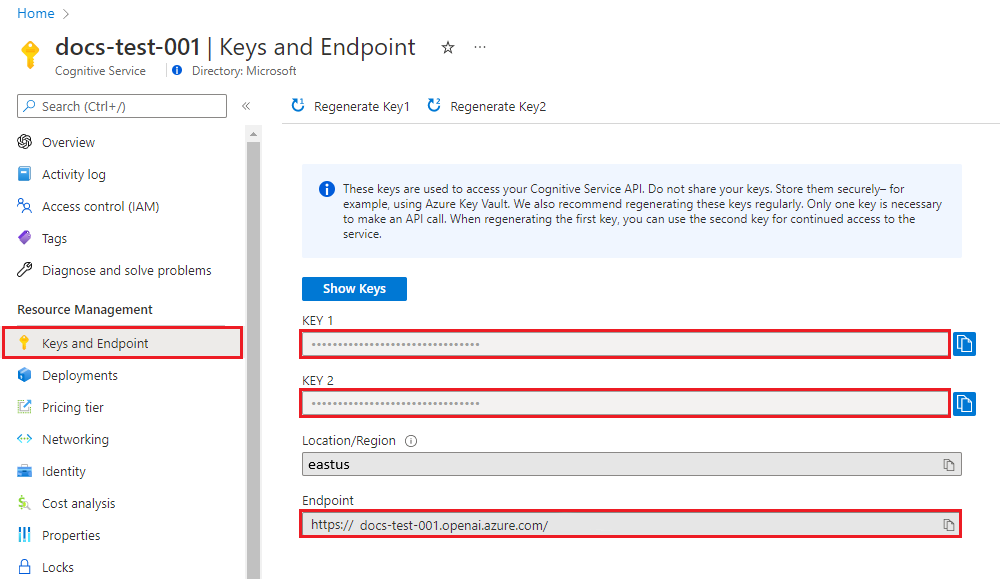

变量名称 值 ENDPOINT 从 Azure 门户检查资源时,可在“密钥和终结点”部分中找到此值。 也可在“Azure AI Studio”>“操场”>“代码视图”中找到该值。 示例终结点为:https://docs-test-001.openai.azure.com/。 API-KEY 从 Azure 门户检查资源时,可在“密钥和终结点”部分中找到此值。 可以使用 KEY1 或 KEY2。 在 Azure 门户中转到你的资源。 可以在“资源管理”部分找到“终结点和密钥”。 复制终结点和访问密钥,因为在对 API 调用进行身份验证时需要这两项。 可以使用 KEY1 或 KEY2。 始终准备好两个密钥可以安全地轮换和重新生成密钥,而不会导致服务中断。

环境变量

为密钥和终结点创建和分配持久环境变量。

- [命令行]

- [PowerShell]

- [Bash]

setx AZURE_OPENAI_KEY "REPLACE_WITH_YOUR_KEY_VALUE_HERE"

setx AZURE_OPENAI_ENDPOINT "REPLACE_WITH_YOUR_ENDPOINT_HERE"

[System.Environment]::SetEnvironmentVariable('AZURE_OPENAI_KEY', 'REPLACE_WITH_YOUR_KEY_VALUE_HERE', 'User')[System.Environment]::SetEnvironmentVariable('AZURE_OPENAI_ENDPOINT', 'REPLACE_WITH_YOUR_ENDPOINT_HERE', 'User')echo export AZURE_OPENAI_KEY="REPLACE_WITH_YOUR_KEY_VALUE_HERE" >> /etc/environment && source /etc/environment

echo export AZURE_OPENAI_ENDPOINT="REPLACE_WITH_YOUR_ENDPOINT_HERE" >> /etc/environment && source /etc/environment

创建新的 Python 应用程序

-

创建名为 quickstart.py 的新 Python 文件。 然后在你偏好的编辑器或 IDE 中打开该文件。

-

将 quickstart.py 的内容替换为以下代码。

- [OpenAI Python 0.28.1]

- [OpenAI Python 1.x]

需要将变量 engine 设置为部署 GPT-3.5-Turbo 或 GPT-4 模型时选择的部署名称。 输入模型名称将导致错误,除非选择的部署名称与基础模型名称相同。

import os import openai openai.api_type = "azure" openai.api_base = os.getenv("AZURE_OPENAI_ENDPOINT") openai.api_key = os.getenv("AZURE_OPENAI_KEY") openai.api_version = "2023-05-15" response = openai.ChatCompletion.create( engine="gpt-35-turbo", # engine = "deployment_name". messages=[ {"role": "system", "content": "You are a helpful assistant."}, {"role": "user", "content": "Does Azure OpenAI support customer managed keys?"}, {"role": "assistant", "content": "Yes, customer managed keys are supported by Azure OpenAI."}, {"role": "user", "content": "Do other Azure AI services support this too?"} ] ) print(response) print(response['choices'][0]['message']['content'])需要将变量 model 设置为部署 GPT-3.5-Turbo 或 GPT-4 模型时选择的部署名称。 输入模型名称将导致错误,除非选择的部署名称与基础模型名称相同。

import os from openai import AzureOpenAI client = AzureOpenAI( azure_endpoint = os.getenv("AZURE_OPENAI_ENDPOINT"), api_key=os.getenv("AZURE_OPENAI_KEY"), api_version="2023-05-15" ) response = client.chat.completions.create( model="gpt-35-turbo", # model = "deployment_name". messages=[ {"role": "system", "content": "You are a helpful assistant."}, {"role": "user", "content": "Does Azure OpenAI support customer managed keys?"}, {"role": "assistant", "content": "Yes, customer managed keys are supported by Azure OpenAI."}, {"role": "user", "content": "Do other Azure AI services support this too?"} ] ) print(response.choices[0].message.content)-

使用快速入门文件中的 python 命令运行应用程序:

python quickstart.py

输出

{ "choices": [ { "finish_reason": "stop", "index": 0, "message": { "content": "Yes, most of the Azure AI services support customer managed keys. However, not all services support it. You can check the documentation of each service to confirm if customer managed keys are supported.", "role": "assistant" } } ], "created": 1679001781, "id": "chatcmpl-6upLpNYYOx2AhoOYxl9UgJvF4aPpR", "model": "gpt-3.5-turbo-0301", "object": "chat.completion", "usage": { "completion_tokens": 39, "prompt_tokens": 58, "total_tokens": 97 } } Yes, most of the Azure AI services support customer managed keys. However, not all services support it. You can check the documentation of each service to confirm if customer managed keys are supported.了解消息结构

GPT-35-Turbo 和 GPT-4 模型经过优化,可以处理格式化为对话的输入。 变量 messages 传递一组字典,这些字典在由系统、用户和助手划定的对话中具有不同角色。 系统消息可用于通过包含有关模型应如何响应的上下文或说明来启动模型。

-

-