- 汕头网站建设优化指南(从0到1打造高质量网站的技巧)

- 门户网站有哪些值得关注的?

- 东莞百度推广优化公司如何选择?

- 网络搭建的基本概念与实践技巧

- 网络平台建站(从零开始的网站建设教程)

- 如何打造一个优秀的建站网站

- 公司网站制作流程(详解网站建设流程与注意事项)

- 设计公司网站设计报价明细表(让你知道每一项费用的来源和计算方法)

- 公司网站创建方案策划的关键步骤和注意事项

- 打造属于你的个性化APP,让你成为行业翘楚

- 苏州制作公司网站的选择指南(从这几个方面入手,让你的网站更加优秀)

- 如何选择适合自己的推广平台网站(一份详细对比报告)

- 如何免费建立自己的网站(完整步骤分享,无需任何技术)

- 建设银行官网全面介绍(功能特色使用方法一网打尽)

- 网页设计案例分析探讨成功的案例与技巧

- 云南网站设计流程详解

- 农产品网络营销怎么做更有效?

- 公司做网站需要多少钱?建议了解这些费用因素

- 网站建设需要多少钱?(从基础建设到维护,全方位解读网站建设成本)

- 网站建设的详细步骤(从零开始,让你轻松建立一个成功的网站)

- 网站设计建设收费标准(详解网站建设的收费标准)

- 暂无可用关键词,请重新输入

- 建立平台与搭建平台有什么区别?

- 如何制定一份完美的东莞网站制作计划(从需求分析到上线实践全面解析)

- SEO推广是什么?如何让你的网站更上一层楼?

- 旅游网站毕业论文(探讨旅游网站的设计与优化)

- 建筑行业招聘网站大揭秘建筑英才网

- 石家庄网站建设公司哪家好?

- 最常用的网页制作软件有哪些?

- 如何快速获取高质量的图片素材?

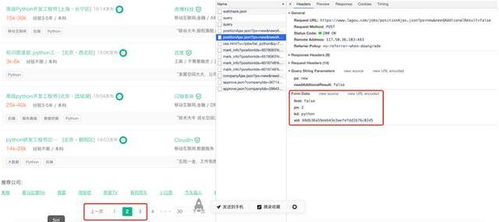

Python作为一门广泛应用于数据分析、人工智能等领域的编程语言,同时也被众多开发者们用于爬虫的开发。在这篇文章中,我会分享一些利用Python打造高效爬虫的小技巧。

第一步:确定所需数据

在进行爬虫开发之前,我们需要明确自己想要获取哪些数据。如果想要爬取一些简单的数据,比如图片或者文字,这些都可以直接从网页源代码中抽取出来。但如果对有些网站的数据需要进行处理,那么可以通过BeautifulSoup或其他类似的库进行解析。

例如,如果要爬取某物流公司的运单数据,我们需要从网站多个页面抓取运单号、省份、城市等信息。这时,我们可以使用BeautifulSoup和XPath技术提取所需数据。

第二步:设置请求头

在进行爬虫过程中,我们需要带有请求头的HTTP请求。这有助于我们模拟使用浏览器进行访问。一些反爬虫的网站会阻止没有请求头或者爬虫特有的请求头的HTTP请求。为了避免这种情况,我们需要设置请求头。

以使用requests库为例子,我们可以在请求中添加一个headers字段:

import requests

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.3'

}

r = requests.get('http://www.baidu.com', headers=headers)

第三步:注意网站反爬技术

除了设置请求头以外,一些网站还需要注意反爬虫技术。比如,某些网站会实时反爬虫并记录下来,同时还会添加验证码,需要手动填写验证码才能继续访问页面。有一些使用Selenium的自动化测试库可以自动填写验证码,但对于反爬虫技术更强的网站还需要依靠其他技术进行解决。

例如,反爬虫网站可能会为了识别机器人而添加Javascript计算机运算。此时我们可以使用PyV8将Javascript运算引擎嵌入到Python中解决相关问题。

第四步:使用多线程

如果爬取网站的数据比较多且需要时长较长,将会大大的降低效率。在此情况下,我们可以使用多线程技术来使爬虫效率提升。

例如,请求网站的响应和解析HTML代码是两个独立的过程,可以使用多线程将这两个过程分别进行处理。 requests-HTML库就是一种可以在多线程中使用的爬虫库。

总结

在这篇文章中,我们介绍了使用Python开发爬虫的几个小技巧。通过确定所需数据、设置请求头、注意网站反爬技术和使用多线程等方法,可以大大提高我们的爬虫效率。当然,在实践中我们还需要根据各种不同情况进行具体调整和优化。